Transformer模型稀疏化訓練與推理加速技術實戰

時間:2025-04-07 來源:華清遠見

Transformer模型稀疏化訓練與推理加速技術實戰

時間:2025-04-07 來源:華清遠見

1. 引言

Transformer模型廣泛應用于自然語言處理(NLP)、計算機視覺(CV)等領域。然而,由于其計算復雜度高、參數規模大,在訓練和推理過程中通常面臨高計算資源消耗的問題。為了提高Transformer的效率,稀疏化訓練與推理加速技術成為研究熱點。

本文將詳細介紹Transformer模型的稀疏化訓練方法,并結合實際案例演示如何實現推理加速。

2. Transformer模型計算復雜度分析

Transformer的計算復雜度主要由自注意力(Self-Attention)機制決定。在標準的全連接注意力機制中,計算量隨著輸入序列長度 ( n ) 增加呈 二次增長:

0(nnd)

其中:

n:輸入序列的長度(token 數)

O(n^2):自注意力計算涉及每個 token 與其他所有 token 交互,導致二次復雜度增長

d :投影計算和前饋層處理隱藏狀態的計算復雜度,( d ) 是隱藏層維度。因此,對于長文本或高分辨率圖像,計算和存儲開銷都非常大。

這就是為什么當序列長度 n 增大時,計算量會迅速膨脹,成為推理和訓練的瓶頸。

3. 稀疏化訓練方法

稀疏化訓練主要通過減少不重要的計算和參數量,提高計算效率。以下是幾種常見的稀疏化策略:

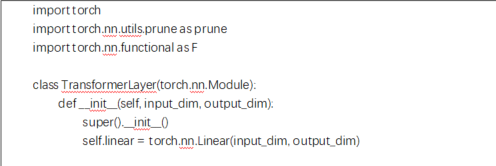

3.1 剪枝(Pruning)

剪枝是一種在訓練過程中減少不重要權重的方法,主要有以下幾種類型:

- 非結構化剪枝:直接去除接近零的權重,適用于密集層。因為這些層通常包含大量冗余參數。相比結構化剪枝,非結構化剪枝不會改變網絡的拓撲結構,但可以減少計算開銷。

- 結構化剪枝:去除整個神經元、注意力頭或整個層,以減少計算復雜度并提高模型效率,使模型更加高效。

PyTorch實現權重剪枝

3.2 稀疏注意力機制

Sparse Attention 通過僅計算部分注意力權重,降低計算復雜度。

- 局部注意力(Local Attention):僅關注臨近的token,類似CNN的感受野。

- 分塊注意力(Blockwise Attention):將序列劃分為多個塊,僅計算塊內的注意力。

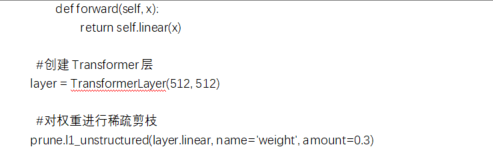

- 滑動窗口注意力(Sliding Window Attention):在局部窗口內計算注意力,如Longformer。

- Longformer 是一種優化的 Transformer 變體,專門用于處理長文本。它通過滑動窗口注意力(Sliding Window Attention)來減少計算復雜度,從標準 Transformer 的 O(n^2) 降低到 O(n),使得處理大規模文本更加高效。

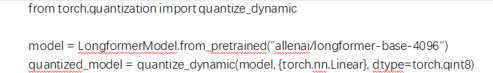

使用Longformer的滑動窗口注意力

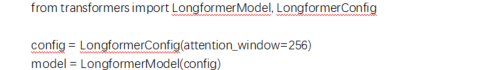

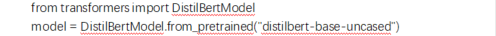

3.3 知識蒸餾(Knowledge Distillation)

知識蒸餾是一種模型壓縮技術,通過讓小模型(Student)模仿大模型(Teacher)的行為,使得小模型在減少計算開銷的同時,盡可能保持與大模型相近的精度。

Hugging Face知識蒸餾

4. Transformer推理加速技術

在推理過程中,可以采用以下方法加速計算。

4.1 低比特量化(Quantization)

量化將模型參數從32位浮點數(FP32)轉換為8位整數(INT8)或更低精度的數據類型,以減少計算量。

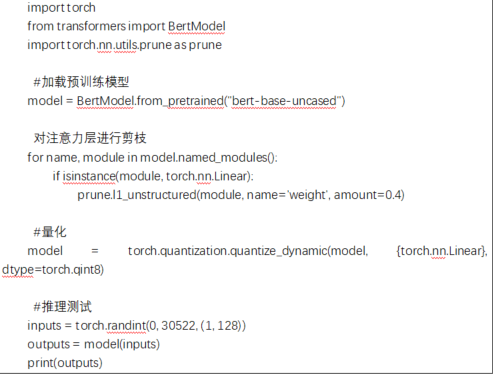

使用PyTorch進行量化

4.2 張量并行與模型并行

對于大規模Transformer,可以使用張量并行(Tensor Parallelism) 和 模型并行(Model Parallelism) 來分布計算,提高推理速度。

使用DeepSpeed進行模型并行

5. 加速BERT模型推理

我們以BERT模型為例,采用剪枝+量化的方式進行推理加速。

6. 結論

通過剪枝、稀疏注意力、知識蒸餾、量化等技術,可以有效減少Transformer模型的計算開銷,提高訓練和推理效率。

推薦組合優化策略:

1. 訓練階段:知識蒸餾 + 剪枝

2. 推理階段:量化 + 稀疏注意力

华清图书馆

0元电子书,限时免费申领10本华清图书PDF版

扫码关注华清远见公众号